INTRODUCCIÓN

El coronavirus SARS-CoV-2 es un nuevo tipo de coronavirus que puede afectar a las personas y que se detectó por primera vez en diciembre de 2019 en la ciudad de Wuhan, provincia de Hubei, en China. Desde marzo de 2020 esta enfermedad por coronavirus (COVID-19) fue declarada por la Organización Mundial de la Salud (OMS) como pandemia. Una de sus características es el alto nivel de contagio, lo que ha provocado su llegada a casi todas las latitudes del planeta. Hasta la fecha, se han reportado más de 212 millones de personas infectadas y más de 4,4 millones han muerto.(1)

El estándar dorado para diagnosticar el COVID-19 es la identificación del ARN viral mediante la reacción en cadena de la polimerasa con transcripción inversa (RT-PCR, por sus siglas en inglés). Sin embargo, este método tiene algunas limitaciones. Una de ellas es su modesto rendimiento diagnóstico y el retraso en la obtención de resultados. Es decir, la toma de muestras introduce una variabilidad muy elevada, dependiendo del lugar, el personal y la carga viral del individuo en ese momento.(2) Por tanto, la prueba disminuye su sensibilidad si no se aplica en un periodo de tiempo determinado.(3,4)

La rápida propagación del coronavirus y los graves efectos que provoca en el ser humano hacen imprescindible el diagnóstico precoz de la enfermedad.(5) El hecho de que el COVID-19 manifieste alteraciones pulmonares ha llevado a un gran número de estudios a basarse en el análisis de imágenes radiográficas de tórax para determinar su presencia.(3) Sin embargo, prestigiosas sociedades radiológicas han manifestado que este tipo de imágenes no deben ser utilizadas como método diagnóstico.(6,7)

Por otro lado, se ha publicado un gran número de trabajos basados en visión por computadora que identifican COVID-19 a partir de radiografías de tórax.(8,9,10,11) Estos trabajos alcanzan índices de rendimiento muy superiores a los reportados por los especialistas humanos. La mayoría de estas investigaciones se basan en técnicas de aprendizaje profundo (DL, Deep Learning). No obstante, una de las limitaciones de las técnicas basadas en DL se conoce como aprendizaje de atajos.(12) Es decir, los modelos aprenden características que logran separar correctamente las clases, pero lo hacen basándose en características espurias. Por tanto, aprenden características que no se relacionan con la etiqueta que se intentan predecir. Este defecto lleva a que los modelos tengan tasas de rendimiento muy altas cuando se evalúan sobre conjuntos que provienen de la misma distribución. Sin embargo, no ocurre lo mismo cuando la evaluación se realiza sobre un conjunto que no procede de la misma distribución.

Esta investigación se centra en la revisión de artículos basados en imágenes de rayos X de tórax (CXR), ya que esta modalidad de imagen es ampliamente utilizada en el diagnóstico y seguimiento de los pacientes y presenta algunas ventajas en comparación con la modalidad de TC, especialmente en los pacientes positivos a la COVID-19.

El objetivo de este trabajo es presentar puntos débiles de los modelos propuestos hasta el momento para diagnosticar COVID-19 a partir de imágenes de CXR de forma autónoma, utilizando técnicas de inteligencia artificial (IA). También, alertar a los investigadores y revisores sobre el problema del aprendizaje por atajo. Este problema ha sido ignorado en casi todos los trabajos revisados en el contexto de la COVID-19(13) y en otros campos de clasificación automática de imágenes.(12) En esta investigación se analiza una de las vías existentes para comprobar si los métodos se ven afectados por el aprendizaje por atajos. En concreto, se revisan los estudios que hacen uso de la inteligencia artificial explicable (XAI) para determinar las regiones que más contribuyen a la clasificación.

MÉTODOS

Se realizó una revisión bibliográfica, que incluye artículos que abordan el uso de técnicas de inteligencia artificial explicable para la identificación automática de COVID-19 basado en radiografías de tórax. Además, se localizaron artículos que utilizan conjuntos de datos externos para realizar la evaluación de los modelos propuestos.

Esta tarea se realizó a partir del uso del Google académico con palabras reservadas como “COVID-19”, “CXR”, “XAI”, “Automatic Classification”. A partir de los resultados obtenidos se decidió discutir 18 artículos los cuales reflejan el problema que se trata en esta investigación. Se incluyen 50 referencias que sirven de base a dicha discusión.

DESARROLLO

Importancia de las imágenes por CXR y por TC en el manejo oportuno de pacientes positivos a COVID-19

Sin duda, las imágenes médicas de los pulmones son una herramienta importante para ayudar a los especialistas, tanto en el manejo de pacientes con infecciones respiratorias agudas (IRA) como para confirmar otras enfermedades. En el caso de la COVID-19, los estudios confirman anormalidades visibles en la región pulmonar de algunos pacientes, sirviendo así como herramienta de decisión para los especialistas humanos.(14)

Es importante tener en cuenta que existen pacientes con PCR positiva que no desarrollan signos o síntomas, por lo que es imposible diagnosticarlos mediante una imagen radiológica de sus pulmones.

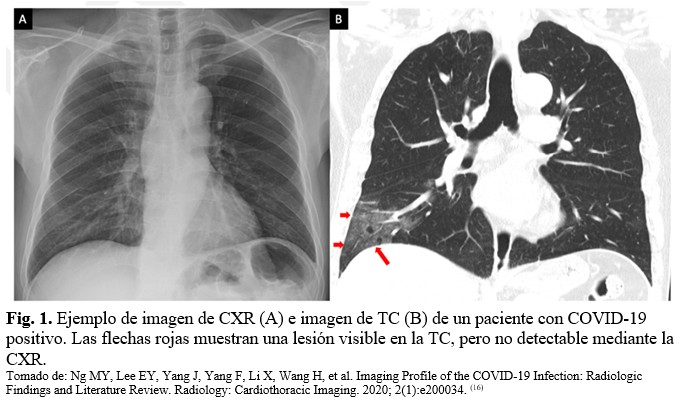

Las imágenes de TC presentan una mayor sensibilidad como método de diagnóstico y seguimiento en comparación con la CXR. Por ejemplo, se han descrito casos de COVID-19 con lesiones visibles en la TC, pero no visibles en la CXR.(15)

De hecho, uno de los principales hallazgos en las imágenes de TC de los pacientes con COVID-19 son las opacidades en vidrio esmerilado en las regiones periféricas de los lóbulos inferiores, las cuales en ocasiones no se pueden apreciar en las imágenes de CXR, como se muestra a continuación: (Fig. 1).

Sin embargo, en la mayoría de los centros de salud no se dispone del equipamiento necesario para adquirir la imagen de TC. Además, si existe un equipo de TC, no es posible dedicarlo exclusivamente a este diagnóstico en particular, dada la alta cantidad de pacientes infectados por COVID-19 existentes y la presión asistencial. Por otro lado, la CXR tiene la ventaja de estar disponible en la mayoría de los centros sanitarios. Su costo es mucho menor en comparación con la imagen de TC, y existe una modalidad portátil que evita que el paciente se mueva, minimizando la posibilidad de propagación del virus. Esto hace que se prefiera esta modalidad de imagen CXR, aunque sea menos sensible para el diagnóstico y el seguimiento del paciente.

El uso de esta técnica como método diagnóstico ha mostrado una baja sensibilidad (Se) y especificidad (Sp) en la práctica radiológica actual en pacientes asintomáticos o con enfermedad de grado leve a medio.(17) Por ejemplo, según Ippolito y cols.(18) la sensibilidad alcanzada utilizando CXR para detectar la neumonía por SARS-CoV-2 fue de 57 %, y en el trabajo de Cartiglioni y cols.(19) fue de 65 %. Estos valores demuestran la dificultad por parte de los radiólogos para hacer un diagnóstico de COVID-19 utilizando la CXR.

El aprendizaje por atajos en la clasificación de CXR

El uso de métodos de DL ha sido ampliamente estudiado en el campo de las imágenes CXR.(20) Asimismo, algunos trabajos reportan evidencias sobre la existencia de aprendizaje por atajos.(21,22) Por ejemplo, Zech JR y cols.(23) lograron identificar el hospital de origen de la radiografía con más del 95 % de exactitud (Acc). De acuerdo con el mapa de activación de la red, se observó que, para lograr este resultado, el modelo se basó en las etiquetas de texto de las imágenes CXR, en lugar de la región del pulmón. Esto demuestra que el rendimiento de las CNN en el diagnóstico de enfermedades mediante radiografías puede reflejar no sólo su capacidad para identificar hallazgos específicos de la enfermedad en la imagen, sino también su capacidad para explotar información de confusión.

Los modelos actuales de DL para la identificación de COVID-19 utilizando imágenes de CXR no escapan del problema del aprendizaje por atajo. Por ejemplo, el estudio desarrollado por Maguolo G.(24) consigue realizar una clasificación con más del 90 % de Acc, sin utilizar la región del pulmón. Esto evidencia que los modelos tienen mucha información que explotar que no está relacionada con las manifestaciones de la enfermedad en la región pulmonar. Por otro lado, Roberts M. y cols.(25) reconocen que la mayoría de los trabajos publicados no han realizado ningún análisis para demostrar la fiabilidad de las predicciones de la red, lo que en el contexto de las soluciones médicas cobra especial relevancia. Es decir, la mayoría de los trabajos del estado del arte han validado sus resultados con conjuntos de datos que contienen decenas o unos pocos cientos de muestras de COVID-19, lo que limita el impacto de las soluciones propuestas. Como se propone en este estudio, una de las formas de obtener una mayor fiabilidad de los métodos es utilizar técnicas que visualicen las regiones en las que se centran los modelos.

Es importante señalar que la mayoría de las investigaciones publicadas hasta ahora se basan en imágenes de diferentes fuentes. Tras la publicación del conjunto de datos de imágenes de Cohen y otros,(26) en el que se pone a disposición de la comunidad científica internacional un conjunto de imágenes positivas a la COVID-19, se han realizado numerosos trabajos aplicando técnicas de IA para la clasificación automática de enfermedades. Es decir, hasta la fecha, ésta ha sido la fuente de imágenes COVID-19 positivas más utilizada por la comunidad científica.

La fórmula utilizada por la mayoría de las investigaciones para aumentar el número de imágenes negativas (no COVID-19) ha sido añadir imágenes de conjuntos disponibles en otras fuentes. Una explicación detallada de los conjuntos actuales, así como sus limitaciones, aparece en los trabajos de García.(27,28) Esta forma de generar los conjuntos de imágenes hace que los modelos entrenados puedan estar aprendiendo a determinar la fuente de proveniencia de imagen en lugar de la enfermedad que se intenta clasificar.(9,11,24)

Los métodos de diagnóstico automático requieren la interpretación de los especialistas humanos, lo que ayuda a confiar en sus decisiones. De hecho, una de las líneas de investigación actuales es el desarrollo de métodos de XAI.(29) En concreto, en el campo de las aplicaciones médicas basadas en imágenes, es esencial una explicación adecuada de la decisión obtenida. Es decir, un sistema de apoyo a la decisión debe ser capaz de sugerir el diagnóstico y mostrar, lo mejor posible, qué contenidos de la imagen han contribuido a la decisión. Además, estos métodos, como se ha comentado anteriormente, son una forma de evaluar la veracidad de los modelos. Por lo tanto, a través de estas técnicas es posible verificar si realmente se presta atención a las regiones que deben ser utilizadas para el diagnóstico.

Análisis de las técnicas XAI

Las técnicas XAI también se han aplicado en el entorno de la detección automática de COVID-19 a partir de la CXR. Existen algunos trabajos publicados hasta la fecha que hacen uso de estas herramientas XAI. Se reportan varias técnicas, entre las más utilizadas están LIME,(30) Grad-Cam,(31) y Grad-Cam++.(32)

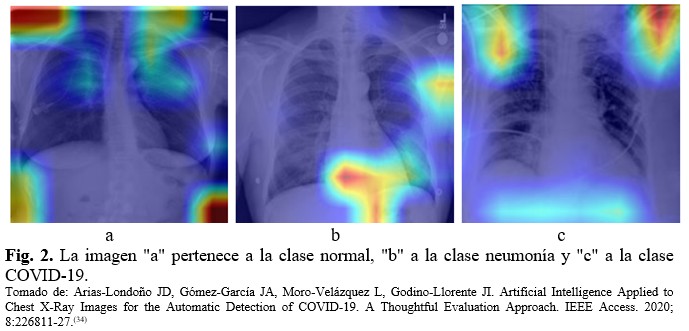

La figura 2 muestra el mapa de activación para una modificación de la CNN COVID-Net,(33) obtenida a partir del método Grad-Cam, se usó toda la imagen para realizar la clasificación. Obsérvese que en todos los casos las regiones en las que se basa la red para realizar la clasificación están fuera de los pulmones. Esto significa que hay regiones que proporcionan suficiente información para separar adecuadamente las clases, pero las características utilizadas para la clasificación no están relacionadas con la enfermedad que se intenta clasificar. En otras palabras, el modelo sufre de aprendizaje por atajo. (Figura 2).

En el trabajo de Tsiknakis(35) se evaluó el resultado de los mapas de atención por dos radiólogos. Estos reportan que el modelo, la mitad de las veces, se centró en regiones fuera de los pulmones para realizar la clasificación. Por otro lado, en el estudio de De Grave y cols.(13) se aplicó la técnica CycleGAN, la cual generó imágenes sintéticas clasificadas correctamente por el clasificador. Estas imágenes generadas mostraron las marcas textuales como patrones importantes para determinar la clase. Asimismo, en otro trabajo se utilizaron mapas de saliencia, los cuales resaltaron con frecuencia los marcadores de lateralidad en las imágenes CXR, que difieren en estilo entre los conjuntos de datos COVID-19 negativo y COVID-19 positivo, y de forma similar resaltaron flechas y otras anotaciones que aparecen exclusivamente en el conjunto de datos.(26)

Una de las variantes para mitigar estos errores es usar una imagen segmentada de los pulmones. Es decir, no aplicar la segmentación lleva a los modelos a utilizar regiones fuera del área pulmonar, marcándolas como importantes para la clasificación.(36) Por lo tanto, los estudios que utilizan la imagen completa para realizar la clasificación y logran resultados espectaculares (nótese que son más de 30 puntos porcentuales en relación con los especialistas en radiología) no son válidos, aunque se publiquen en revistas revisadas por pares.

Por ejemplo, en el trabajo de Arias(34) se evaluaron las regiones de imagen que más contribuyeron a la identificación de COVID-19 utilizando tres variantes de imagen. En el primer experimento, se utilizó la imagen completa y, de nuevo, se observó que el modelo tomaba regiones fuera de los pulmones para realizar la clasificación. En el segundo experimento, se utilizó la región del cuadro delimitador de los pulmones, donde también apareció el mismo problema que en el experimento anterior. Por último, en el tercer experimento se utilizó una imagen de los pulmones segmentada, lo que obligó al método a encontrar las características dentro de estas regiones. Esta vez los resultados obtenidos fueron inferiores a los obtenidos con las variantes anteriores, demostrando así que, al utilizar las variantes anteriores, los modelos utilizan características que no están relacionadas con la patología a identificar.

Otro intento de evaluar visualmente las regiones que un modelo utiliza para determinar la clase es el reportado por Teixeira y cols.(37) En ese estudio se demostró que, al utilizar la imagen completa como entrada, las CNNs señalaban como regiones importantes aquellas que no pertenecían a los pulmones. Al igual que en el trabajo de Grave y cols.(13) los modelos basaron su atención en las etiquetas presentadas en las imágenes. En ese estudio también se observó que los modelos fueron capaces de identificar con gran precisión el lugar de origen de las imágenes. Esto ocurrió incluso después de aplicar la segmentación pulmonar. Por lo tanto, hay características ocultas en las imágenes que pueden ser explotadas por los modelos para realizar la clasificación y que deben ser tratadas con cuidado para conseguir modelos fiables.

Por ejemplo, las características demográficas de la población pueden ser un fuerte factor de confusión. Obsérvese que varios trabajos han utilizado conjuntos de imágenes en los que una de las clases pertenece a los niños.(28) Por otro lado, los pacientes con COVID-19 muestran artefactos como electrodos y sus cables, algunos están intubados. Además, la posición de los pacientes puede afectar ya que, en los pacientes sanos, la vista de rayos X suele ser AP y en otros casos como COVID-19, los pacientes están en posición supina y la vista es PA.(9,10)

En correspondencia con los trabajos revisados, los métodos XAI se han utilizado para determinar las regiones de la imagen que más contribuyen a la clasificación y así construir modelos más fiables. Esto ha evidenciado que utilizar la imagen completa conduce a marcar como regiones importantes aquellas que no se relacionan con lo que se quiere identificar, lo que invalida los resultados obtenidos.

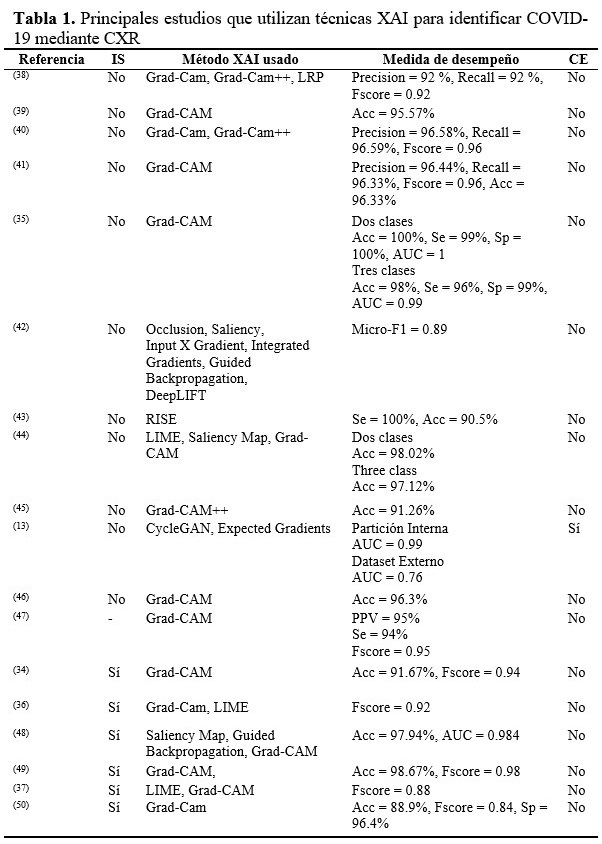

Por otra parte, la segmentación de los pulmones no garantiza que los modelos se centren realmente en las regiones adecuadas y pueden contener características subyacentes que enmascaren el buen rendimiento de los modelos. No obstante, como puede verse en la tabla 1, hay estudios que, informando de las regiones en las que se basan sus modelos y sabiendo que no corresponden a la enfermedad que tratan de identificar, informan de altos índices de eficacia en la clasificación. Esto evidencia la presencia de aprendizaje por atajos, así como la omisión de este problema por parte de la comunidad científica.

De ahí que sea necesario un conjunto de evaluaciones externas como complemento para demostrar que los modelos mantienen su comportamiento. A pesar de esto, no se reporta este tipo de estrategia para la evaluación de los modelos en ninguno de los estudios que utilizan las técnicas XAI revisadas.

La tabla también registra la presencia de métodos de segmentación (IS) para determinar la región pulmonar. Esto es de vital importancia, pues cuando no se utiliza sólo la región pulmonar, los modelos tienden a centrarse en regiones que parecen imposibles de correlacionar con la enfermedad. (Tabla 1).

CONCLUSIONES

En este artículo se revisan los principales enfoques utilizados en la literatura científica para abordar el problema de la clasificación automática de la COVID-19 utilizando imágenes de rayos X. Según los trabajos revisados, los índices de rendimiento reportados por los clasificadores automáticos superan a los especialistas humanos en más de 30 puntos porcentuales. Se observó, basándose en la revisión de los trabajos publicados que utilizan XAI, que las CNN basan más su atención en las regiones fuera del área del pulmón para realizar la clasificación. Esto sugiere que estas redes están realizando un aprendizaje por atajos.

Por otro lado, en la mayoría de los estudios revisados no se utilizó un conjunto de evaluación externo para determinar el poder de generalización de los modelos. Esto demuestra que los modelos propuestos hasta ahora aprenden patrones que no están relacionados con la enfermedad que intentan clasificar. Por tanto, las soluciones propuestas hasta el momento no parecen ser adecuadas para su uso en entornos hospitalarios. Se debe tener presente que los pacientes pueden evolucionar negativamente si no reciben el tratamiento médico adecuado.

Conflicto de intereses

Los autores plantean que no existe conflicto de intereses.

Contribuciones de los autores

Conceptualización de ideas: José Daniel López-Cabrera.

Investigación: José Daniel López-Cabrera, Marlen Pérez-Díaz.

Visualización: José Daniel López-Cabrera.

Redacción del borrador original: José Daniel López-Cabrera.

Redacción, revisión y edición: José Daniel López-Cabrera, Marlen Pérez-Díaz.

Financiación

Programa Sectorial Tecnologías de Aplicaciones Nucleares, el láser, la óptica y la ultrasónica para producir y generalizar bienes y servicios. Título del proyecto “Desarrollo de Sistemas automatizados de apoyo al diagnóstico médico a partir de imágenes radiológicas con el empleo de Inteligencia artificial”.